È possibile sintetizzare tutte le conoscenze da noi espresse nelle lezioni precedenti, direttamente connesse con le caratteristiche, la struttura, e la dinamica delle particelle e delle loro interazioni, in un unico modello coerente in ogni sua parte, in grado di prevedere nuovi fenomeni e di spiegare tutti quelli già osservati? La risposta è sì. Dall'unione fra il Modello a Quark, l'Elettrodinamica Quantistica e la Cromodinamica Quantistica nacque quello che l'epistemologo Thomas Kuhn (1922-1996), noto filosofo della scienza, avrebbe chiamato il "paradigma" scientifico più valido ed efficace nel campo della Fisica delle Particelle: il Modello Standard. Esso riesce a spiegare con successo la composizione subnucleare della materia osservabile mediante un numero limitato di componenti elementari indivisibili, considerati puntiformi. Questi costituenti fondamentali sono i seguenti:

Le particelle-massa sono quelle che costituiscono tutta la materia a noi nota. Sicuramente fanno parte di questa categoria i sei quark e i corrispondenti antiquark previsti da Murray Gell-Mann, di cui abbiamo parlato nella lezione ad essi dedicata. I quark sono i costituenti degli adroni, cioè dei barioni e dei mesoni. E i leptoni? A tutt'oggi, essi sono considerati puntiformi, cioè privi di una struttura interna. Della famiglia dei leptoni fa parte l'elettrone e, che ha carica – 1 e spin 1 / 2, ma anche il muone μ, che ha la stessa carica dell'elettrone ma una massa 207 volte maggiore (105,6 MeV/c2), e spin 1 / 2. Come abbiamo detto in un'altra lezione, il muone fu scoperto nel 1936 da Carl Anderson (1905-1991) e dal suo studente Seth Neddermeyer (1907-1988) mentre studiavano i raggi cosmici. In 2,2 x 10−6 s esso decade in un elettrone, un neutrino e un antineutrino. A queste due particelle si aggiunse la particella tau o tauone τ, scoperta negli esperimenti condotti tra il 1974 e il 1977 da Martin Lewis Perl (1927-2014) e dai suoi colleghi allo SLAC; grazie ad essi a Perl fu conferito il Premio Nobel nel 1995. Tale particella ha una carica pari a quella dell'elettrone, una massa di 1777 MeV/c2 (quasi 3500 volte quella dell'elettrone e quasi il doppio di quella del protone) e un'emivita di appena 2.9 x 10−13 s. Il tau è l'unico leptone che può decadere in adroni, attraverso l'interazione debole, essendo l'unico che ha la massa sufficiente per farlo; per esempio, il tau può decadere in un pione negativo, un pione neutro e un neutrino. Ecco il diagramma di Feynman del decadimento del leptone tau:

A questi tre leptoni vanno aggiunti i neutrini, particelle postulate nel 1930 da Wolfgang Pauli (1900-1958) per spiegare lo spettro continuo del decadimento beta e scoperte solo 22 anni dopo, nel 1956, dai fisici Clyde Cowan (1919-1974) e Frederick Reines (1918-1998) nel corso di un esperimento eseguito al reattore a fissione di Savannah River, che mostrò reazioni indotte proprio da neutrini liberi. I neutrini sono fermioni (hanno spin 1 / 2) come tutte le altre particelle-massa e sono privi di carica. Dopo essere stato considerati a lungo privi di massa, esperimenti condotti negli anni Duemila hanno mostrato che essi hanno una massa non nulla, da 100.000 a un milione di volte inferiore a quella dell'elettrone, con valore più probabile intorno a 0,05 eV/c2. Poiché i neutrini interagiscono debolissimamente con le altre particelle, quando si muovono attraverso la materia le loro possibilità di interazione sono molto piccole: occorrerebbe un muro in piombo spesso addirittura un anno luce per bloccare la metà dei neutrini che lo attraversano! Per questo i rivelatori di neutrini di solito contengono centinaia di tonnellate di materiale, costruito in modo tale che pochi atomi al giorno interagiscano con i neutrini entranti. I maggiori rivelatori di neutrini al mondo sono il Super-Kamiokande, costruito nel 1983 in Giappone nella prefettura di Gifu; il Liquid Scintillator Neutrino Detector (LSND) a Los Alamos (Nuovo Messico), avviato nel 1993; l'esperimento BooNE (Booster Neutrino Experiment) presso il Fermilab, attivato nel 1997; e soprattutto l'esperimento GALLEX (Gallium Experiment), attivo dal 1991 al 1997, realizzato in Italia nei Laboratori Nazionali del Gran Sasso dell'INFN, situati nel traforo del Gran Sasso d'Italia. L'esperimento GALLEX in particolare usava la seguente reazione per catturare i neutrini:

νe + 71Ga → 71Ge + e−

Un grande successo dei primi rivelatori di neutrini lo si ebbe il 23 febbraio 1987, quando esplose la Supernova 1987a nella Grande Nube di Magellano, a 168.000 anni luce dalla Terra, e fu rilevata una grande quantità di neutrini provenienti dal nucleo della stella in fase di collasso.

Nel 1962 Leon Max Lederman (1922-), Melvin Schwartz (1932-2006) e Jack Steinberger (1921-) dimostrarono che esiste più di un tipo di neutrini, scoprendo il neutrino muonico, distinto dal neutrino elettronico, scoperta che ha fatto vincere loro il premio Nobel per la Fisica nel 1988. Nell'estate del 2000 il progetto DONUT del Fermilab permise di scoprire un terzo tipo di neutrino, il neutrino tauonico, già previsto nel 1975 dopo la scoperta del tauone, in seguito all'osservazione dell'energia e della quantità di moto mancanti nei decadimenti del tauone, analoghi al decadimento beta che ha portato alla scoperta del neutrino elettronico. Esistono dunque tre tipi differenti di neutrino, detti sapori: il neutrino elettronico νe, il neutrino muonico νμ e il neutrino tauonico ντ, in diretta relazione con i tre leptoni del Modello Standard: elettrone, muone e tauone. La misura della larghezza di decadimento del bosone Z0 al Large Electron-Positron Collider di Ginevra ha permesso di dimostrare che esistono solo tre tipologie di neutrini aventi massa minore di 45 GeV e che interagiscono attraverso la forza nucleare debole. Dei neutrini riparleremo diffusamente in una prossima lezione.

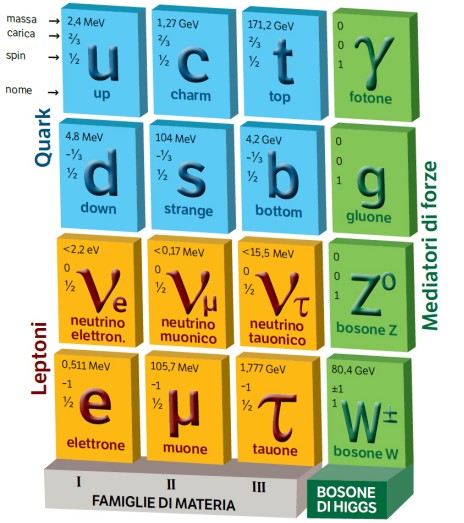

Abbiamo così sei quark e sei leptoni. Queste dodici particelle-massa possono essere a loro volta suddivise in tre famiglie o generazioni. La prima famiglia comprende il quark up u, il quark down d, l'elettrone e e il neutrino elettronico νe (con le rispettive antiparticelle). La seconda famiglia comprende il quark charm c, il quark strange s, il muone μ e il neutrino muonico νμ. La terza famiglia comprende il quark top t, il quark bottom b, il tauone τ e il neutrino tauonico ντ. Praticamente tutta la materia di cui è formato il nostro universo è costruita usando solo le particelle della prima famiglia, perchè protoni e neutroni, costituenti dei nuclei atomici, sono costruiti con quark up e down, e con gli elettroni costituiscono tutti gli atomi. Le particelle delle altre due famiglie possono essere prodotte solo nelle collisioni ad alta energia, attraverso la trasformazione dell'energia in materia, e a differenza di quelle della prima sono instabili, e finiscono per decadere nei quark up e down, nell'elettrone, nel neutrino elettronico o nelle loro antiparticelle.

Nessuno sa perchè le famiglie siano tre e solo tre: questo è uno dei misteri più affascinanti lasciati irrisolti dal Modello Standard. È possibile il mescolamento tra le tre famiglie, ovvero la trasformazione delle particelle di una famiglia in quelle dell'altra? Sì, grazie ad un meccanismo introdotto per la prima volta nel 1963 dal grande fisico italiano Nicola Cabibbo (1935-2010), da lui pensato per due sole famiglie. Cabibbo ipotizzò che la forza debole agisse in maniera diversa su particelle con e senza carica di stranezza, e introdusse una costante nota come angolo di Cabibbo θc; il quadrato del seno e del coseno di quest'angolo corrispondono alla probabilità che una particella strana si trasformi in una particella non strana interagendo con un'altra particella per mezzo della forza debole, cioè la probabilità che, a seguito dell'emissione di un astenone W±, un quark strange si trasformi in un quark up o viceversa. Il processo di interazione così identificato viene chiamato corrente debole carica. Sperimentalmente si trova che l'angolo di Cabibbo vale θc = 13,1°, e quindi sin2 θc = 0,05 e cos2 θc = 0,95. Ne consegue che le interazioni a cui è associato il seno dell'angolo sono molto più improbabili di quelle a cui è associato il coseno. Ciò significa che un quark down ha molte più probabilità di emettere un astenne W± e diventare un quark up di quante non ne abbia, nel corso dello stesso processo, di divenire un quark s. Nel 1973 il modello proposto da Cabibbo fu ampliato da Makoto Kobayashi (1944-) e Toshihide Maskawa (1940-), che ipotizzarono l'esistenza di una terza famiglia di quark (i quark top e bottom) e introdussero la matrice CKM che utilizza nove numeri per calcolare quanta probabilità ha ciascun quark di diventare un qualsiasi altro quark durante un processo di interazione debole. Essa fu utilizzata tra l'altro per spiegare la violazione della simmetria CP.

Nicola Cabibbo (Roma, 10 aprile 1935 – 16 agosto 2010)

Il Modello Standard, inoltre, fornisce una descrizione coerente delle quattro forze fondamentali agenti tra le particelle: quella elettromagnetica, quella nucleare debole, quella nucleare forte e quella gravitazionale (quest'ultima è del tutto trascurabile a livello subnucleare, e il Modello praticamente la ignora). Ogni forza è trasmessa da un quanto di campo, cioè da una particella-forza; le particelle-forza hanno spin intero, e quindi sono bosoni, a differenza delle particelle-massa, che sono fermioni. Anche se le quattro forze hanno effetti notevolmente diversi tra di loro, tali differenze tendono a diminuire all'aumentare dell'energia delle particelle; infatti, abbiamo già visto che ad energie superiori ai 100 GeV la forza elettromagnetica e quella nucleare debole possono essere descritte come un'unica interazione, detta forza elettrodebole.

Il Modello Standard, derivato direttamente dalla Teoria Quantistica di Yang e Mills, elaborata negli anni cinquanta, prevede dunque in totale:

Come si vede, si arriva in totale a ben 55 particelle, che possono essere ridotte, trascurando le antiparticelle, le cariche di colore e il gravitone, alle sedici che vedete raggruppate nello schema soprastante: sei quark colorati in azzurro, sei leptoni colorati in giallo e quattro bosoni colorati in verde. O almeno, alle sedici che sembra di vedere a colpo d'occhio. Se osservate bene, sotto le quattro particelle-forza colorate in verde ce n'è una quinta, di cui è visibile solo il nome. Qual è lo scopo di questo nuovo inquilino del Modello Standard, apparentemente intruso, visto che non si conosce alcuna "quinta forza" da affiancare alle quattro già note?

Invece uno scopo c'è eccome. Studiando le proprietà delle particelle-forza, ci si rende conto che il fotone e il gluone sono privi di massa (il gluone potrebbe averne una, ma estremamente piccola), mentre invece i mediatori dell'interazione nucleare debole sono assai massicci. Questa asimmetria ha turbato a lungo i sonni dei fisici, almeno quanto il problema del perchè nel nostro universo la materia prevale sull'antimateria. Per quale motivo certe particelle sono dotate di massa, e altre no? I primi a cercare di rispondere a questa domanda furono, nel 1964, i britannici Peter Higgs (1929-2024) e Thomas Kibble (1932-2016), i belgi François Englert (1932-) e Robert Brout (1928-2011) e gli americani Gerald Stanford Guralnik (1936-2014) e Carl Richard Hagen (1937-). Essi ipotizzarono l'esistenza di un campo di energia che permea l'intero spazio, oggi chiamato campo di Higgs, mediato da una nuova particella chiamata Bosone di Higgs. Il bosone e il campo di Higgs furono incorporati nel Modello Standard indipendentemente da Steven Weinberg e Abdus Salam nel 1967. Il Bosone di Higgs, indicato con H0, ha spin zero, è l'antiparticella di se stesso e il valore della sua massa non è previsto dal Modello Standard, che si limita a fornire un valore compreso tra 120 e 200 GeV.

Il campo elettromagnetico ha sede nella carica elettrica, quello gravitazionale nella massa e quello nucleare forte nella carica di colore. Invece il campo di Higgs non ha sede in una sorta di carica, ma in ogni momento riempie tutto lo spazio, e i bosoni si addensano intorno a particolari particelle, conferendo loro esattamente la massa che noi misuriamo. Per comprendere quello che è stato definito il "meccanismo di Higgs", ricorriamo ad una metafora. Immaginiamo una grande stanza in cui si sta tenendo una festicciola tra studenti; in essa vi sono molte ragazze, intente a mangiare e a chiacchierare tra di loro. Se entra nella stanza un ragazzino secchione ed occhialuto, molto probabilmente le ragazze lo ignoreranno e lo lasceranno solo, cosicché egli (ahimé) non avrà difficoltà a passare indisturbato in mezzo a loro, viaggiando praticamente in linea retta, e ad uscire dalla parte opposta della stanza. Se invece entra un ragazzone muscoloso, palestrato, elegante e con il gel sui capelli, è altamente probabile che le ragazze si affolleranno ammirate intorno a lui, circondandolo e cercando di attaccare bottone con lui. Questo però gli renderà difficile muoversi all'interno della stanza, costringendolo ad avanzare lentamente e a zig-zag, e farà fatica anche a fermarsi, molto più di quanto non capitava allo studente poco popolare.

La stessa cosa accade nel campo di Higgs. L'universo è densamente affollato di bosoni di Higgs virtuali, che si creano e si distruggono in continuazione; se essi si concentrano intorno ad una particella, interagendo continuamente con essa, la ostacolano nel suo moto, conferendole un'inerzia, e quindi una massa. Se invece una particella non è in grado di interagire con il campo di Higgs, può muoversi liberamente in linea retta, e si comporta come un corpuscolo privo di massa. Questo modello spiega benissimo la cosiddetta rottura di simmetria da parte dell'interazione elettrodebole che, a differenza delle altre forze, a basse energie è mediata da bosoni con massa relativamente grande. Attorno alle particelle W± e Z0 infatti i bosoni di Higgs si addensano maggiormente, mentre fotoni, gluoni e gravitoni non riescono ad interagire con essi e si muovono indisturbati in linea retta, risultando privi di massa.

Naturalmente la sfida era quella di osservare sperimentalmente il Bosone di Higgs, o meglio i suoi prodotti di decadimento. Il nostro H0 si formerebbe attraverso la fusione di due gluoni e subito decadrebbe in due astenoni Z0, di cui uno virtuale. Questi ultimi possono decadere secondo meccanismi diversi, per esempio in due coppie elettrone-positrone e muone-antimuone, come mostra il seguente diagramma di Feynman:

La massa del bosone di Higgs è fondamentale per comprendere con quali modalità possa decadere: visto che non può essere rilevato direttamente, dalla misurazione delle coppie leptone-antileptone che si formano nell'anello del CERN si può stabilire se la loro fonte è stata proprio H0 oppure no.

La caccia era già iniziata negli anni Novanta del secolo scorso con il LEP di Ginevra, il quale aveva permesso di escludere per la sua massa valori inferiori a 114,5 GeV, ma i risultati furono inconcludenti. Non fu più fortunato l'acceleratore Tevatron presso il Fermilab, il quale era riuscito solo ad escludere l'esistenza di un bosone di Higgs con massa compresa tra 160 e 170 GeV. Ma nel 2008 divenne operativo l'LHC del Cern, progettato apposta (tra le altre cose) per scovare l'introvabile bosone. Il 13 dicembre 2011, in un seminario presso il CERN, venne illustrata una serie di dati degli esperimenti ATLAS e CMS, coordinati dai fisici Fabiola Gianotti (1960-) e Guido Tonelli (1950-), che individuavano il bosone di Higgs in un intervallo di energia fra i 124 e 126 GeV con una probabilità prossima al 99 %. Benché tale valore fosse sicuramente notevole, la fisica delle alte energie richiede che, prima di poter annunciare ufficialmente una scoperta, sia raggiunta una probabilità di errore dovuto al caso o a fluttuazioni quantistiche non superiore allo 0,00006 %, un valore espresso in termini statistici con l'espressione "cinque sigma" in termini di deviazioni standard.

L'evento osservato dal CMS che ha permesso la scoperta del Bosone di Higgs

Il 5 aprile 2012, nell'anello che corre con i suoi 27 km sotto la frontiera tra Svizzera e Francia, venne raggiunta l'energia massima mai toccata di 8 TeV, e il 4 luglio 2012, in una conferenza tenuta nell'auditorium del CERN, presente Peter Higgs, i portavoce dei due esperimenti, Fabiola Gianotti per l'esperimento ATLAS e Joseph Incandela (1956-) per l'esperimento CMS, diedero l'annuncio ufficiale della scoperta di una particella compatibile con il bosone di Higgs, la cui massa risultò intorno ai 126,5 GeV secondo ATLAS e ai 125,3 GeV secondo CMS. Non fu possibile osservare direttamente il bosone di Higgs, che vive solo 1,56 x 10−22 secondi, ma gli scienziati hanno visto le particelle in cui si decompone. La scoperta venne ufficialmente confermata il 6 marzo 2013, nel corso di una conferenza tenuta dai fisici del CERN a La Thuile, e l'8 ottobre 2013 Peter Higgs e François Englert sono stati insigniti del premio Nobel per la Fisica per la scoperta del meccanismo di Higgs.

Nell'estate 2020 inoltre l'analisi dei dati di ATLAS e di CMS ha permesso ai fisici delle particelle di individuare la prova diretta che il campo di Higgs è davvero il meccanismo che dà massa ai muoni: i due esperimenti presso l'LHC hanno infatti mostrato che il bosone di Higgs può decadere in due muoni, anche se questo evento è molto raro (capita una volta ogni 5000 interazioni). Ciò dimostra che i muoni si accoppiano con il campo di Higgs, da cui ottengono la loro massa.

Grazie alla grancassa dei mass media, che hanno riportato la notizia della sua scoperta in modo semplificato e a volte addirittura fuorviante, il bosone di Higgs è noto al grande pubblico e ai media come "la particella di Dio", epiteto derivante dal titolo del saggio divulgativo di Leon Lederman "The God Particle: If the Universe Is the Answer, What Is the Question?", pubblicato nel 1993. Ma l'equivoco deriva da un cambiamento imposto dall'editore al titolo del libro, che avrebbe dovuto suonare "The Goddamn Particle", cioè "la particella maledetta", originalmente scelto dall'autore in riferimento alla difficoltà della sua individuazione. Per di più "The God Particle" in Italia è stata erroneamente tradotta con "la particella di Dio" (che in inglese suonerebbe "God's particle") al posto dell'esatta traduzione "la particella-dio". Così scriveva Elena Dusi su "La Repubblica" del 4 luglio 2012, per giustificare tale errata traduzione: « Senza quel minuscolo frammento di materia teorizzato dal fisico scozzese in appena tre settimane estive del 1964, tutte le particelle elementari dell'universo sarebbero infatti state prive di massa. Ma la massa è sorgente di forza di gravità. E senza la forza di gravità descritta da Newton non c'è attrazione fra gli atomi, le molecole, le stelle, i pianeti e gli esseri viventi. Il bosone di Higgs appena scoperto al Cern è una sorta di colla che tiene insieme l'universo, ed è anche per questo che si è guadagnato il soprannome di "particella di Dio", con un termine poco amato dai fisici e giudicato dallo stesso Higgs "inutilmente offensivo nei confronti di alcuni credenti". » (da questo link) Per questo, io eviterò sempre di utilizzare questo epiteto assolutamente improprio.

L'importanza della scoperta di questa particella è stata tale che l'antenato del bisonte europeo, rappresentato innumerevoli volte nelle pitture rupestri lasciate dai nostri antenati sulle pareti delle spelonche in cui vivevano, è stato battezzato dai paleontologi "bisonte di Higgs", alludendo al fatto che l'origine di questa specie è stata a lungo avvolta nel mistero, esattamente come la nostra particella, individuata il 4 luglio 2012 dopo quasi cinquant'anni di ricerche a vuoto (per inciso, nell'ottobre 2016 Julien Soubrier dell'Università di Adelaide ha dimostrato che il bisonte europeo o Bison bonasus è frutto di un incrocio avvenuto circa 120.000 anni fa fra l'antico ed estinto bisonte delle steppe o Bison priscus e l'antenato degli attuali bovini o Bos primigenius: anche il bisonte di Higgs, alla fine, è stato acciuffato!)

Peter Higgs (Newcastle upon Tyne, 29 maggio 1929 – Edimburgo, 8 aprile 2024)

La scoperta del Bosone di Higgs rappresentò il massimo trionfo scientifico del Modello Standard, che già era stato capace di prevedere l'esistenza (poi confermata sperimentalmente) dei gluoni, degli astenoni W± e Z0, del quark top e del leptone tau. Il Modello Standard sintetizza tutto ciò che noi, uomini degli anni Dieci del XXI secolo, sappiamo sui mattoni fondamentali dell'universo in cui viviamo, ed è stato in grado di risolvere moltissimi problemi che un tempo parevano insolubili. In un certo senso, il Modello Standard È la Fisica del nostro presente. Eppure, nonostante questi successi, esso lascia insolute alcune domande, alle quali dedicheremo le restanti lezioni di questo ipertesto:

Le prime prove di una Fisica che va al di là del modello Standard stanno emergendo già fin da ora, come spiega Guy Wilkinson, fisico delle particelle dell'Università di Oxford, in un avvincente articolo pubblicato sul numero di gennaio 2018 de "Le Scienze". L'esperimento LHCb presso il CERN d Ginevra, del quale Wilkinson è stato a lungo portavoce, ha studiato per anni la cosiddetta "Fisica della Bellezza", cioè i canali di decadimento degli adroni che contengono al loro interno il quark beauty, concentrandosi in particolar modo sui decadimenti del mesone B0, formato da un quark beauty e da un antiquark down. Tra i vari scenari di decadimento di questa esotica particella ve ne sono in particolare due che hanno attirato l'attenzione di Wilkinson e dei suoi colleghi. Nel primo, B0 decade in un mesone D*+, composto da un quark charm e da un antiquark down, un leptone tau e un antineutrino tauonico:

B0 → D*+ + τ− + ντ

Nel secondo scenario invece decade in un mesone K*0, costituito da un quark strange e da un antiquark down, un muone e un antimuone:

B0 → K*0 + μ− + μ+

Il primo decadimento avviene tramite la mediazione di un bosone W−, che decade in un τ− e in un ντ. Invece il secondo è più complicato: il quark beauty oscilla in un pesantissimo quark top, che emette un bosone Z0 e poi oscilla in un quark strange; il bosone Z0 decade in un μ− e in un μ+. Questi decadimenti probabilmente violano la cosiddetta regola dell'universalità leptonica, che è parte integrante del Modello Standard: nell'ambito di tale modello, il bosone B0 ha la stessa probabilità di decadere in un tauone e in un antineutrino tauonico, che di decadere nei membri della famiglia del muone e dell'elettrone, tenendo conto delle loro diverse masse; in altre parole, spiega Wilkinson, le regole di decadimento di W− dovrebbero essere le stesse per tutti i leptoni. Ma l'esperimento LHCb, dopo aver tenuto conto di tutti i possibili fenomeni che potrebbero falsare i decadimenti ora descritti, ha verificato che gli adroni contenenti quark beauty sembrano decadere in un tauoni più spesso che in muoni e in elettroni. La stessa violazione dell'universalità leptonica è stata osservata anche dagli esperimenti BaBar e Belle, che studiano la "Fisica della Bellezza" rispettivamente allo SLAC di Stanford negli Stati Uniti e presso l'High Energy Accelerator Research Organisation in Giappone, ed ormai tale violazione non può più essere ignorata come una fluttuazione statistica dei risultati sperimentali. Le possibili soluzioni dell'enigma dei B0 sono tutte al di fuori del Modello Standard. Secondo alcuni, c'è di mezzo un nuovo tipo di bosone di Higgs carico, perchè i bosoni di Higgs non rispettano l'universalità leptonica e decadono preferibilmente in particelle di massa maggiore, favorendo la generazione di pesanti tauoni; tuttavia, le proporzioni nei quali LHCb ha visto decadere i mesoni B0 in tauoni non collimano bene con le più semplici teorie che prevedono queste specie esotiche di Higgs. Altri fisici delle particelle invocano invece la presenza di una particella Z ', un cugino bizzarro ed assai più pesante dello Z0 di Rubbia, che decadrebbe in leptoni in un modo tutto suo.

Altri ancora propongono di chiamare in causa un leptoquark, un'ipotetica particella che permetterebbe ai quark di trasformarsi in leptoni e viceversa. Si pensa che i leptoquark siano particelle pesantissime, almeno quanto un atomo di piombo, e che decadano assai rapidamente. Ci sarebbero tre tipi di leptoquark composti dai leptoni e dai quark di ogni generazione; un leptoquark di terza generazione, ad esempio, potrebbe decadere in un quark bottom e in un leptone tau. Secondo i sostenitori della loro esistenza, i leptoquark potrebbero spiegare perché esiste lo stesso numero di quark e di leptoni, perchè vi sono tre generazioni di particelle e molte altre somiglianze tra leptoni e quark; inoltre ad altissime energie quark e leptoni potrebbero fondersi in leptoquark, che obbedirebbero ad una Fisica totalmente diversa dal Modello Standard. Nell'estate del 1997 una serie di eventi osservati dall'acceleratore HERA di Amburgo creò scalpore tra i fisici delle particelle, perché una loro possibile spiegazione era il coinvolgimento dei leptoquark; tuttavia, studi successivi condotti da HERA hanno escluso questa possibilità per masse dei leptoquark fino a circa 300 GeV; studi più recenti, condotti mediante l'LHC, hanno portato la massa minima dei leptoquark a circa 1 TeV. Se effettivamente nel decadimento del B0 in muoni è coinvolto un leptoquark di seconda generazione, il quark beauty del mesone B0 si trasformerebbe in un muone e nel fantomatico leptoquark, il quale a sua volta decadrebbe in un quark strange e in un antimuone, come si vede nel diagramma di Feynman sottostante. Quest'ipotesi è molto ingegnosa, spiega l'emissione della coppia muone-antimuone e giustifica i rapporti tra le frequenze dei diversi decadimenti, ma deve fare i conti con i vincoli già imposti da altre misurazioni; ad esempio, bisogna spiegare perchè questi fantomatici Z ' e leptoquark non sono ancora apparsi nelle ricerche effettuate da altri due esperimenti del CERN, ATLAS e CMS. Come ha scritto Wilkinson, è comprensibile che i risultati di LHCb entusiasmino quanti sperano di vedere la nascita di una nuova Fisica, tuttavia i fisici più anziani e più saggi hanno già visto effetti simili emergere e poi scomparire in esperimenti precedenti, e quindi la prudenza è d'obbligo: non sappiamo se la strada verso una nuova fisica al di là del Modello Standard sarà lunga o breve, ma probabilmente LHCb darà un importante contributo a farci fare dei passi avanti lungo questa strada.

Nell'ottobre 2018 è arrivata l'ennesima conferma alla bontà del Modello Standard: le più precise misurazioni di sempre, effettuate dalla collaborazione Advanced Cold Molecule Electron Electric Dipole Moment (ACME) alla statunitense Harvard University, guidato da Gerald Gabrielse (1961-), hanno indicato che l’elettrone è perfettamente sferico, come previsto dal Modello. Per esempio la cosiddetta supersimmetria, di cui parleremo in seguito, prevede che la sua superficie sia in realtà leggermente deformata, come se la distribuzione della carica elettrica, invece di essere uniforme in un volume sferico, fosse allungata in una direzione, a formare un dipolo elettrico. Secondo il modello supersimmetrico, la forma dell'elettrone sarebbe deformata da particelle subatomiche molto massicce, le stesse che potrebbero spiegare l'asimmetria tra materia e antimateria oggi riscontrabile nell'universo. Perfezionando un analogo apparato che aveva dato risultati significativi nel 2014, la collaborazione ACME ha sparato un fascio di molecole di ossido di torio freddo al ritmo di 50 volte al secondo in una camera delle dimensioni di una grande scrivania. All’interno di questa camera, una serie di fasci laser orientano le molecole e i loro elettroni mentre transitano tra due lastre di vetro immerse in un campo magnetico attentamente controllato. Un secondo insieme di fasci laser bersagliano le molecole, che rispondono emettendo una radiazione luminosa, la cui polarizzazione (cioè la direzione lungo cui oscilla il campo elettrico associato all’onda) dipende dall’eventuale esistenza di un dipolo elettrico nell’elettrone. Questo dipolo non è stato rilevato, e il Modello Standard è stato confermato. « Se l’elettrone fosse delle dimensioni della Terra, potremmo rilevare se il suo centro fosse spostato di un milionesimo dello spessore di un capello umano », ha spiegato Gabrielse: « ecco quanto è sensibile il nostro apparato! »

Sul n° 2999 di

"Topolino" è comparsa la

storia a fumetti "Paperoga e il bosino di X", che

fa evidentemente il verso alla scoperta del bosone di Higgs avvenuta l'anno

precedente!

Il fatto è che oggi noi ci troviamo nella stessa situazione in cui si trovava la Fisica negli ultimi anni dell'Ottocento. A quell'epoca vi era una teoria consistente chiamata Fisica Classica, fondata su cinque equazioni, l'equazione di Newton F = m a e le quattro Equazioni di Maxwell, che insieme sembravano in grado di interpretare ogni fenomeno della Natura. Eppure, questa versione della Fisica era minata dalle fondamenta dall'intima inconciliabilità tra la meccanica classica e l'elettromagnetismo classico. Infatti l'equazione di Newton era invariante per le Trasformazioni di Galileo, ma le equazioni di Maxwell non lo erano: erano invece invarianti rispetto alle Trasformazioni di Lorentz, dedotte per via teorica ed inconciliabili con la Meccanica newtoniana, giacché sembravano rendere lo spazio e il tempo non più assoluti, ma relativi al sistema di riferimento. Inoltre, la Fisica Classica era incapace di spiegare certi fastidiosi fenomeni che sembravano sfuggire ad ogni possibile interpretazione. In particolare, era pressoché impossibile spiegare perchè, come risultato dell'esperienza di Michelson e Morley, la velocità della luce sembrava avere lo stesso identico valore nella direzione lungo la quale si muoveva nello spazio intorno al Sole e in direzione opposta, in chiaro contrasto con la meccanica galileiana (la velocità della Terra avrebbe dovuto sommarsi a quella della luce nel primo caso e sottrarsi da essa nel secondo); inoltre, restava assolutamente insoluto il problema dello spettro di corpo nero. Considerando quest'ultimo con un insieme di oscillatori armonici di dimensioni atomiche, applicando le equazioni di Maxwell risultava che l'intensità della radiazione emessa avrebbe dovuto aumentare indefinitamente all'aumentare della sua frequenza ("catastrofe ultravioletta"), in evidente contrasto con l'esperienza: l'intensità della radiazione emessa raggiungeva un massimo dato dalla Legge di Wien, e poi diminuiva fino a zero. Questi due problemi apparivano, nel panorama della fisica classica, come due grosse macchie di sporco su un muro appena verniciato di nuovo. Ma proprio l'insolubilità di tali questioni convinsero i Fisici più coraggiosi dell'inadeguatezza della Fisica Classica a trattare certe situazioni, come quelle legate alla propagazione di corpi alla velocità della luce, o alla struttura atomica degli elementi. Per risolvere il dilemma posto dall'esperienza di Michelson e Morley, nel 1905 Albert Einstein mise in cantiere la Teoria della Relatività Ristretta, che andava manifestamente al di là della Fisica newtoniana, mentre per prevedere correttamente lo spettro di corpo nero nel 1900 Max Planck suggerì che la radiazione scambiasse energia con la materia solo sotto forma di pacchetti discreti, detti quanti e così diede il via alla gloriosa stagione della Meccanica Quantistica.

Allo stesso modo, oggi abbiamo tra le mani una costruzione teorica che sembra funzionare a perfezione: il Modello Standard, capace di prevedere l'esistenza di nuove particelle prima che esse vengano osservate, e di giustificare i valori delle loro grandezze caratteristiche. Ma il Modello Standard, come la Fisica Classica, è minato alle radici dalla sostanziale inconciliabilità tra la Meccanica Quantistica, valida su scale piccolissime, e la Relatività Generale di Einstein, valida su scale grandissime. Nei casi in cui queste due grandi branche della Fisica dovrebbero essere utilizzate insieme, come per studiare i buchi neri, singolarità piccolissime dotate di una grande massa, oppure per penetrare i segreti del Big Bang, le due teorie dimostrano di essere del tutto incompatibili. Inoltre, al di là della mancanza di una Gravitodinamica Quantistica, cioè di una teoria quantistica del campo gravitazionale, fenomeni come l'oscillazione dei neutrini, la materia oscura e l'energia oscura restano del tutto inspiegati. Tutto questo ci fa sospettare che, come la Fisica Classica sia in realtà solo un caso particolare della Relatività di Einstein, a velocità molto più piccole di quella della luce nel vuoto, e della Meccanica Quantistica, su scale macroscopiche e quindi molto maggiori delle dimensioni atomiche, così il Modello Standard sia solo un'approssimazione di nuove teorie molto più generali e anche molto più complicate, che aspettano al varco i Fisici del futuro, e dalle quali l'oscillazione dei neutrini e l'accelerazione dell'universo emergeranno in maniera naturale. Queste sono le avvincenti sfide che attendono la Fisica di Domani, e noi cercheremo di tratteggiare queste sfide a partire dalla prossima lezione.

I miei studenti in visita al CERN di Ginevra il 21 marzo 2023